NVIDIA A100 موتور محرک پلتفرم دیتاسنتری انویدیا محسوب میشود و بهعنوان مؤلفهی هستهای، وظیفه تأمین توان پردازشی و شتابدهی بارهای کاری پیشرفته در حوزههای هوش مصنوعی (AI)، یادگیری ماشین (Machine Learning) و محاسبات با کارایی بالا (HPC) را بر عهده دارد. این شتابدهنده بر پایه معماری انقلابی NVIDIA Ampere توسعه یافته و جهشی بنیادین در عملکرد GPU ایجاد کرده است؛ بهگونهای که تا ۲۰ برابر عملکرد بالاتر در آموزش مدلهای هوش مصنوعی نسبت به نسل پیشین ارائه میدهد. همچنین فناوری نوآورانه Multi-Instance GPU (MIG) را معرفی میکند که امکان پارتیشنبندی ایزوله GPU و بهرهبرداری بهینه از منابع پردازشی را در میان بارهای کاری متنوع فراهم میسازد.

این راهنمای جامع به بررسی مشخصات کلیدی، توانمندیهای عملکردی و ملاحظات استقرار میپردازد؛ مواردی که متخصصان مراکز داده باید برای ارزیابی یکپارچهسازی A100 در زیرساخت پلتفرم دیتاسنتری انویدیا مدنظر قرار دهند.

مخاطبان این مقاله

این مقاله برای مدیران مراکز داده، مهندسان هوش مصنوعی، پژوهشگران حوزه HPC و تصمیمگیرندگان فناوری اطلاعات که در حال ارزیابی سرمایهگذاری در زیرساختهای مبتنی بر GPU هستند تدوین شده است. چه در حال طراحی کلاسترهای آموزش هوش مصنوعی در مقیاس بزرگ باشید و چه به دنبال بهینهسازی استقرارهای فعلی پلتفرمهای HPC، در این مقاله میتوانید بینشهای عملی و قابل اجرا برای پیادهسازی و پیکربندی A100 به دست آورید.

اهمیت موضوع

NVIDIA A100 به ستون فقرات بسیاری از دستاوردهای تحولآفرین در پژوهشهای هوش مصنوعی تبدیل شده است. این شتابدهنده امکان آموزش مدلهای بهینهسازیشده را فراهم کرده که پیشتر بهدلیل محدودیتهای حافظه و توان پردازشی عملاً غیرقابل اجرا بودند. سازمانهایی که زیرساخت مبتنی بر A100 را مستقر کردهاند، کاهش چشمگیر زمان آموزش، بهبود نرخ بهرهبرداری از منابع از طریق پارتیشنبندی MIG و توانایی مقیاسپذیری کارآمد بارهای کاری هوش مصنوعی از مرحله تحقیق تا محیط عملیاتی (Production) را گزارش کردهاند.

وقتی درباره چنین جهشی صحبت میکنیم، در واقع با ترکیبی از افزایش پهنای باند حافظه، بهینهسازی مسیرهای داده و ارتقای معماری هستههای پردازشی روبهرو هستیم؛ یعنی همان نقاطی که معمولاً گلوگاههای واقعی سیستمهای AI در مقیاس بزرگ هستند.

آنچه خواهید آموخت

این مقاله پوشش فنی کاملی از معماری A100 ارائه میدهد؛ شامل تحلیل ساختار داخلی، بررسی بنچمارکهای عملکرد در سناریوهای آموزش مدلهای هوش مصنوعی (AI Training) و کاربردهای محاسبات با کارایی بالا (HPC)، پیکربندیهای استقرار در سطح دیتاسنتر، و ارائه راهکارهای عملی برای چالشهای متداول در پیادهسازی. تمرکز این مقاله بهطور اختصاصی بر سناریوهای استقرار در مراکز داده است و کاربردهای حوزه مصرفکننده و گیمینگ را در بر نمیگیرد.

در این مقاله با نوآوریهای معماری NVIDIA Ampere و قابلیتهای Tensor Coreهای نسل سوم آشنا میشوید؛ هستههایی که عملیات ماتریسی با دقتهای مختلف (از FP32 تا TensorFloat-32 و BF16) را با راندمان بسیار بالاتر اجرا میکنند.

همچنین پیکربندیهای حافظه A100، شاخصهای کلیدی عملکرد (Throughput، Bandwidth، Latency) و گزینههای فرمفکتور مختلف آن بررسی میشود؛ از نسخههای PCIe گرفته تا ماژولهای SXM برای استقرارهای با چگالی بالا. فناوری Multi-Instance GPU یا MIG بهصورت دقیق تحلیل میشود؛ فناوریای که امکان ایزولهسازی بارهای کاری و تخصیص دقیق منابع GPU را فراهم میکند، بهطوری که هر پارتیشن از منابع اختصاصی حافظه، کش و هستههای پردازشی بهره میبرد.

در نهایت، استراتژیهای استقرار برای پیکربندیهای PCIe و SXM، بههمراه راهکارهایی برای بهینهسازی حافظه، تنظیمات MIG و مدیریت چالشهای زیرساخت توان (Power Delivery و Thermal Design) ارائه میشود؛ همان جایی که مهندسی واقعی دیتاسنتر خودش را نشان میدهد.

آشنایی با معماری GPU NVIDIA A100

NVIDIA A100 پرچمدار پردازندههای گرافیکی دیتاسنتری انویدیا است که بر پایه معماری NVIDIA Ampere توسعه یافته و در سال ۲۰۲۰ با هدف پاسخگویی به رشد نمایی پیچیدگی مدلهای هوش مصنوعی و بارهای کاری تحلیل داده معرفی شد.

بهعنوان جانشین مستقیم NVIDIA V100 مبتنی بر معماری Volta، مدل A100 مجموعهای از بلوکهای پردازشی بازطراحیشده را در خود جای داده که بهطور خاص برای آموزش مدرن AI، استنتاج یادگیری عمیق (Deep Learning Inference) و کاربردهای محاسبات علمی با نیاز شدید به پردازش موازی طراحی شدهاند.

در سطح معماری، A100 تنها یک افزایش ساده در تعداد هستهها نیست. این نسل با بهینهسازی مسیرهای داده، ارتقای Tensor Coreها به نسل سوم، افزایش پهنای باند حافظه HBM2e و پشتیبانی از قابلیتهایی مانند MIG، عملاً یک بازتعریف از مفهوم شتابدهندهی یکپارچه در دیتاسنتر ارائه میدهد.

جایگاه A100 در سبد محصولات دیتاسنتری انویدیا نشاندهنده حرکت راهبردی به سمت «شتابدهی یکپارچه» است؛ مدلی که طیفی از کاربردها، از HPC کلاسیک تا مدلهای پیشرفته هوش مصنوعی مولد را در یک بستر سختافزاری مشترک پشتیبانی میکند. این رویکرد باعث میشود سازمانها بتوانند بدون نگهداری استکهای سختافزاری مجزا برای هر نوع بار کاری، راهکارهای متنوع محاسباتی را روی یک پلتفرم همگرا مستقر کنند.

در عمل، این یعنی همان سیستمی که دیروز شبیهسازی دینامیک مولکولی اجرا میکرد، امروز میتواند مدل ترنسفورمر چندمیلیارد پارامتری را آموزش دهد. این همان نقطهای است که معماری به استراتژی تبدیل میشود؛ جایی که طراحی سیلیکون مستقیماً بر مدل کسبوکار اثر میگذارد.

نوآوریهای معماری Ampere

معماری NVIDIA Ampere با بهرهگیری از فناوری ساخت ۷ نانومتری، امکان مجتمعسازی حدود ۵۴ میلیارد ترانزیستور را در یک تراشه واحد فراهم کرده است؛ عددی که نسبت به نسل پیشین مبتنی بر NVIDIA Volta جهشی چشمگیر در چگالی ترانزیستوری و در نتیجه توان پردازشی ایجاد میکند. این افزایش چگالی صرفاً به معنی «بیشتر بودن» نیست، بلکه به معنی بازطراحی عمیق بلوکهای پردازشی است.

در این معماری، Streaming Multiprocessorها (SM) بازمهندسی شدهاند تا بهرهوری در اجرای عملیات ماتریسی و برداری افزایش یابد. سلسلهمراتب حافظه (Memory Hierarchy) بهینهسازی شده تا تأخیر دسترسی کاهش یافته و پهنای باند مؤثر افزایش پیدا کند. همچنین سیستمهای مدیریت توان پیشرفتهتر، امکان دستیابی به توان عملیاتی بالاتر را در عین حفظ بهرهوری انرژی فراهم میکنند؛ موضوعی حیاتی در مقیاس دیتاسنتری که هر وات اهمیت اقتصادی دارد.

مهمترین پیشرفت اما در Tensor Coreهای نسل سوم رخ داده است. این هستهها اکنون بهصورت بومی از فرمتهای دقت جدیدی مانند TF32 (TensorFloat-32) پشتیبانی میکنند. TF32 بهگونهای طراحی شده که بدون نیاز به تغییر در کدهای موجود، فرایند آموزش مدلهای هوش مصنوعی را شتاب دهد. به بیان فنی، این معماری بهصورت خودکار سطح دقت محاسبات را بر اساس نیاز بار کاری تنظیم میکند و در عین حفظ کیفیت نتایج، زمان آموزش مدلهای بزرگمقیاس را بهطور قابل توجهی کاهش میدهد.

اینجاست که مهندسی هوشمند خودش را نشان میدهد: بهجای وادار کردن توسعهدهنده به بازنویسی کد، سختافزار خودش را با الگوی محاسباتی سازگار میکند. این همان همگرایی معماری و نرمافزار است که باعث شده NVIDIA A100 به یک استاندارد عملیاتی در زیرساختهای AI مدرن تبدیل شود.

فناوری Tensor Core

فناوری Tensor Core در NVIDIA A100 در قلب معماری NVIDIA Ampere قرار دارد؛ جایی که شتابدهی واقعی بارهای کاری هوش مصنوعی و HPC اتفاق میافتد. Tensor Coreهای نسل سوم برای اجرای عملیات ماتریسی عمیق (Matrix Multiply-Accumulate) که اساس یادگیری عمیق هستند بهینهسازی شدهاند و از قالبهای عددی متنوعی مانند TF32 و BF16 پشتیبانی بومی دارند. نتیجه روشن است: آموزش (Training) و استنتاج (Inference) مدلها با سرعت بالاتر و بدون پیچیدگی اضافی در کدنویسی.

در مقایسه با نسل پیشین، توان عملیاتی عملیات ماتریسی Tensor تا دو برابر افزایش یافته است. علاوه بر این، قابلیت Fine-Grained Structured Sparsity با نادیده گرفتن وزنهای صفر در شبکههای عصبی، در سناریوهای استنتاج یک افزایش عملکرد مضاعف (تا ۲ برابر دیگر) فراهم میکند. این بهینهسازی هم برای بارهای کاری تکدقتی (FP32) و هم دودقتی (FP64) مزیت ایجاد میکند؛ بنابراین A100 برای مدلهای AI سنگین و کاربردهای علمی حساس به دقت محاسباتی گزینهای کاملاً مناسب است.

فناوری Tensor Core در چارچوب پلتفرم دیتاسنتری انویدیا طراحی شده و از مقیاسپذیری در سطح زیرساخت پشتیبانی میکند. امکان پارتیشنبندی منابع GPU و اجرای همزمان چندین بار کاری، به سازمانها اجازه میدهد زیرساخت پردازشی خود را متناسب با نیاز، از چند مدل بزرگ تا هزاران پردازش کوچک در چندین نمونه GPU، توسعه دهند. این معماری حتی قابلیت مقیاسپذیری تا هزاران GPU را دارد؛ یعنی همان سطحی که پژوهشهای پیشرفته و استقرارهای سازمانی در آن معنا پیدا میکنند.

از منظر اکوسیستم نرمافزاری، A100 با طیف گستردهای از فریمورکها و کتابخانهها سازگار است، از جمله مجموعه کانتینری و ابزارهای ارائهشده در NVIDIA NGC. این همگرایی سختافزار و نرمافزار باعث میشود سازمانها سریعتر به بینش عملیاتی (Time to Insight) برسند، بهرهوری منابع را افزایش دهند و در رقابت حوزههای AI و HPC مزیت پایدار ایجاد کنند.

در نهایت، Tensor Core فقط یک بلوک سیلیکونی نیست؛ یک فلسفه طراحی است: نزدیک کردن ریاضیاتِ شبکههای عصبی به خودِ سختافزار، تا فاصله میان ایده و اجرا تا حد ممکن کوتاه شود.

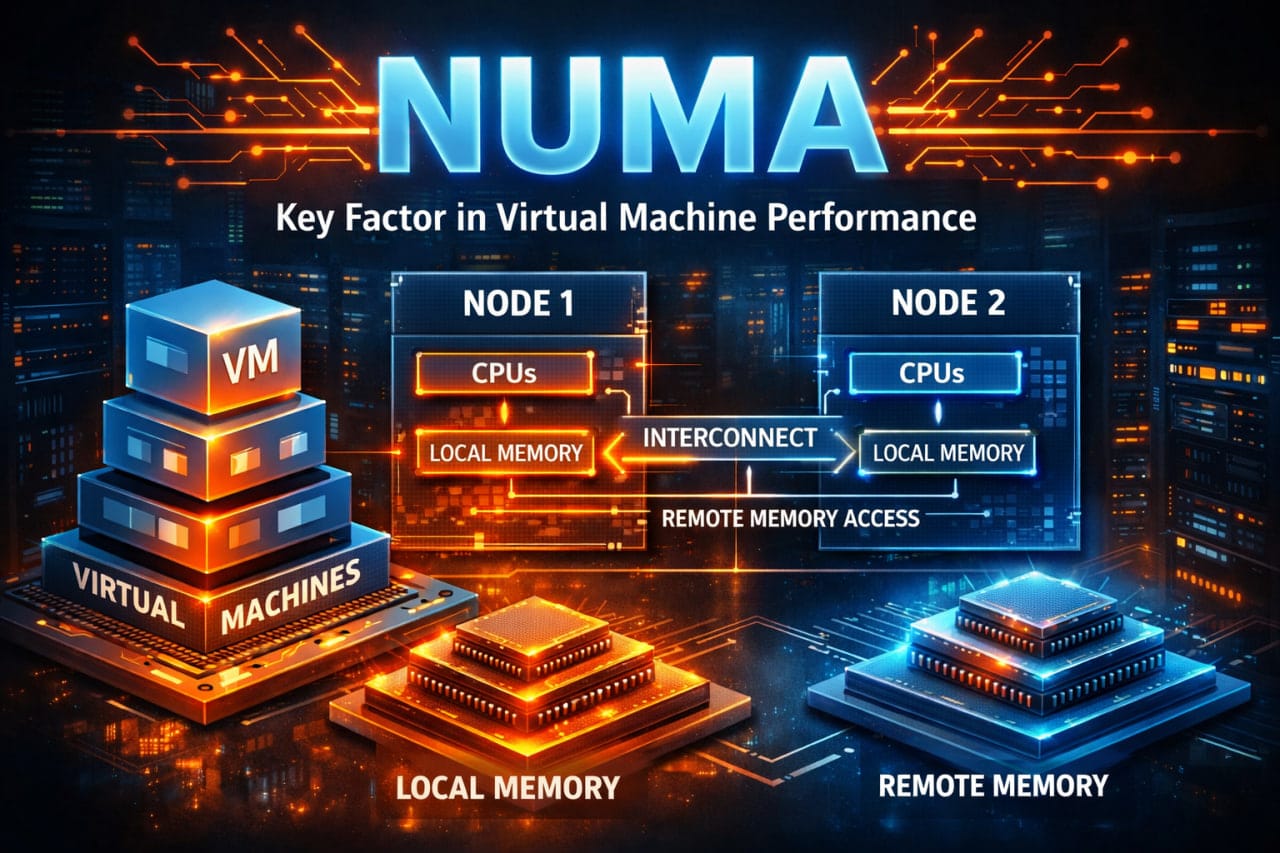

فناوری Multi-Instance GPU (MIG)

قابلیت Multi-Instance GPU یا MIG در NVIDIA A100 این امکان را فراهم میکند که یک GPU فیزیکی به حداکثر هفت نمونه مستقل تقسیم شود؛ هر نمونه مانند یک GPU مجزا با حافظه اختصاصی، کش اختصاصی و منابع پردازشی مجزا عمل میکند. این قابلیت بر پایه انعطافپذیری تخصیص منابع در معماری NVIDIA Ampere توسعه یافته و به مراکز داده اجازه میدهد بارهای کاری را بهصورت کارآمد و متناسب با تقاضا مقیاس دهند.

در عمل، MIG اجازه میدهد چندین کاربر یا سرویس بهطور همزمان از یک GPU استفاده کنند، بدون آنکه منابع بهصورت اشتراکی و بیقاعده مصرف شود. هر کاربر سهم مشخص و تضمینشدهای از حافظه، پهنای باند و هستههای پردازشی دریافت میکند؛ بنابراین عملکرد پایدار (Performance Consistency) و قابلیت پیشبینیپذیری حفظ میشود.

نکته کلیدی، ایزولهسازی در سطح سختافزار است. هر نمونه MIG در سطح سیلیکون از سایر نمونهها جداست، به این معنا که بارهای کاری نمیتوانند بر یکدیگر تأثیر بگذارند. این سطح از جداسازی باعث میشود بهرهوری کلی GPU در سناریوهای چندکاربره به حداکثر برسد، در حالی که ریسک تداخل عملکردی از بین میرود. چنین قابلیتی برای ارائهدهندگان خدمات ابری و مؤسسات پژوهشی که باید بهطور همزمان چند پروژه یا چند تیم را پشتیبانی کنند، مزیتی راهبردی محسوب میشود.

در واقع، MIG پاسخ مستقیم به یک مسئله کلاسیک دیتاسنتری است: چگونه یک منبع بسیار قدرتمند را بدون اتلاف، بین چند مصرفکننده تقسیم کنیم، آن هم بدون افت کیفیت. این معماری نشان میدهد که مقیاسپذیری فقط به معنای افزودن سختافزار بیشتر نیست؛ گاهی به معنای تقسیم هوشمندانهتر همان سختافزار موجود است.

درک این زیرساختهای معماری، بستر لازم را برای بررسی دقیق قابلیتهای عملکردی و گزینههای پیکربندی A100 فراهم میکند؛ جایی که تئوری طراحی به سناریوهای عملی استقرار تبدیل میشود.

مشخصات فنی و قابلیتهای عملکردی A100

مشخصات فنی NVIDIA A100 تجسم عملی نوآوریهای معماری NVIDIA Ampere هستند؛ جایی که طراحی سیلیکون به شاخصهای قابل اندازهگیری در آموزش AI، استنتاج و محاسبات علمی تبدیل میشود. اینجا دیگر درباره شعار صحبت نمیکنیم، درباره عدد و پهنای باند و ظرفیت واقعی حرف میزنیم.

بیشتر بخوانید: سیر تا پیاز معرفی پردازنده گرافیکی NVIDIA A100

مشخصات حافظه و پهنای باند

A100 در دو پیکربندی حافظه ۴۰ گیگابایت و ۸۰ گیگابایت عرضه میشود که هر دو از فناوری حافظه با پهنای باند بالا HBM2e استفاده میکنند. نسخه PCIe با ۴۰ گیگابایت حافظه HBM2e، پهنای باندی در حدود 1.55 ترابایت بر ثانیه ارائه میدهد. نسخه ۸۰ گیگابایتی این عدد را به حدود 2 ترابایت بر ثانیه میرساند؛ سطحی از پهنای باند که در میان GPUهای دیتاسنتری تولید انبوه، در بالاترین رده قرار میگیرد.

این ظرفیت حافظه بالا به سازمانها اجازه میدهد مدلهای بزرگتر هوش مصنوعی را بدون نیاز به پیادهسازی راهبردهای پیچیده Model Parallelism آموزش دهند؛ راهبردهایی که معمولاً سربار ارتباطی و پیچیدگی نرمافزاری ایجاد میکنند. پهنای باند عظیم HBM2e نیز تضمین میکند که دسترسی به داده به گلوگاه تبدیل نشود، بهویژه در سناریوهای پردازش فشرده که نرخ انتقال داده تعیینکننده عملکرد نهایی است.

معماری حافظه یکپارچه (Unified Memory Architecture) نیز امکان دسترسی شفاف به کل فضای حافظه را برای اپلیکیشنها فراهم میکند، بدون آنکه نیاز به مدیریت دستی و پیچیده حافظه باشد. نتیجه این طراحی، کاهش اصطکاک توسعه نرمافزار و افزایش بهرهوری در محیطهای عملیاتی است؛ همان نقطهای که سختافزار قدرتمند باید با سادگی مهندسی همراه شود.

شاخصهای عملکرد در AI و HPC

NVIDIA A100 در قالبهای دقت مختلف، عملکردی ارائه میدهد که متناسب با نوع بار کاری بهینه شده است. این انعطاف در سطح Precision همان جایی است که معماری هوشمند خودش را نشان میدهد.

در سناریوهای آموزش هوش مصنوعی (AI Training)، این GPU با استفاده از Tensor Coreها و دقت FP16 میتواند تا حدود 312 ترافلاپس (TFLOPS) توان پردازشی ارائه دهد. پشتیبانی از BF16 نیز امکان آموزش مدلهای بزرگتر را با پایداری عددی بهتر فراهم میکند؛ یعنی کاهش ریسک خطاهای تجمعی در محاسبات ماتریسی عمیق، بدون افت محسوس در سرعت.

در نسلهای قبلی معمولاً برای دستیابی به عملکرد مطلوب در بارهای کاری متفاوت، نیاز به بهینهسازیهای مجزا یا حتی پلتفرمهای سختافزاری جداگانه وجود داشت. اما در معماری NVIDIA Ampere، Tensor Coreهای پشتیبان دقت دوگانه (FP64) قادرند تا حدود 9.7 ترافلاپس عملکرد در محاسبات علمی ارائه دهند. این یعنی همان سختافزاری که یک مدل زبانی عظیم را آموزش میدهد، میتواند شبیهسازیهای عددی حساس در حوزههای فیزیک، مهندسی یا مدلسازی اقلیمی را نیز اجرا کند.

برای بارهای کاری استنتاج (Inference)، استفاده از دقت INT8 توان پردازشی را به حدود 1,248 ترافلاپس عملیاتی بر ثانیه (TOPS) میرساند. این سطح از کارایی امکان پردازش بلادرنگ (Real-Time) مجموعهدادههای بزرگ را با حداقل تأخیر فراهم میکند؛ موضوعی حیاتی در کاربردهایی مانند بینایی ماشین صنعتی، تحلیل ویدئو یا سامانههای تصمیمگیری آنی.

در نهایت، نکته کلیدی این است که A100 با بازی هوشمندانه میان دقت عددی و توان پردازشی، اجازه میدهد هر بار کاری در «نقطه بهینه خودش» اجرا شود؛ نه بیش از حد دقیق و کند، نه بیش از حد سریع و ناپایدار. این همان مهندسی تعادل در مقیاس سیلیکون است.

گزینههای فرمفکتور

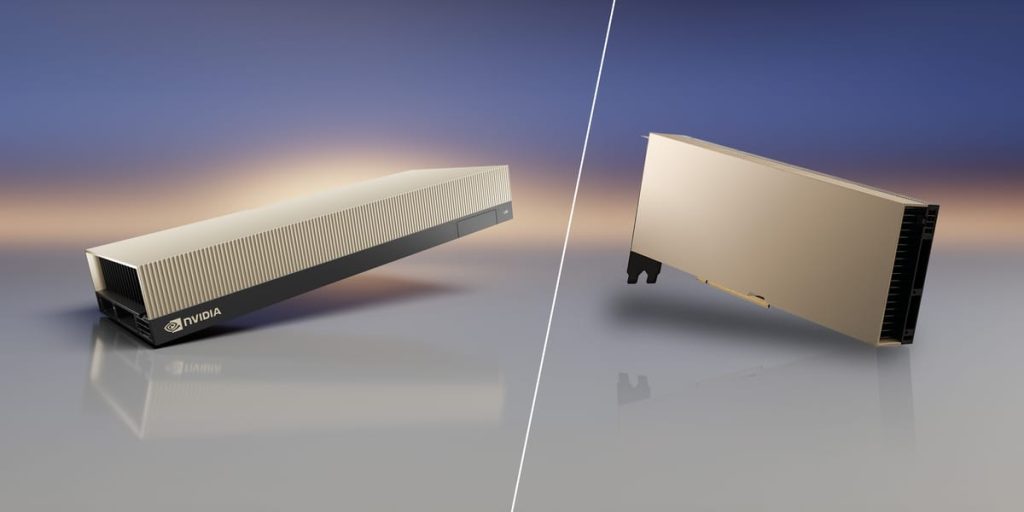

NVIDIA A100 در دو فرمفکتور PCIe و SXM عرضه میشود، که هر کدام برای سناریوهای استقرار خاص بهینهسازی شدهاند. نسخههای PCIe با توان مصرفی طراحیشده ۲۵۰ وات (TDP) مناسب ادغام در سرورهای استاندارد هستند، در حالی که ماژولهای SXM تا ۴۰۰ وات TDP پشتیبانی میکنند و از ارتباط پرسرعت NVIDIA NVLink برای مقیاسبندی چند GPU بهره میبرند.

فناوری NVLink امکان ارتباط مستقیم GPU به GPU را با پهنای باند ۶۰۰ گیگابایت بر ثانیه فراهم میکند. این ویژگی اجازه میدهد سیستمها بدون محدودیتهای PCIe، بهصورت کارآمد بین چند دستگاه A100 مقیاسپذیری داشته باشند؛ موضوعی حیاتی در آموزش مدلهای AI بزرگمقیاس که نیازمند هماهنگی دقیق بین چند GPU هستند.

نکات کلیدی

- پیکربندیهای حافظه از مدلهایی با ظرفیت تا ۸۰ گیگابایت بدون نیاز به تقسیمبندی پشتیبانی میکنند.

- عملکرد در قالبهای دقت FP64، FP32، FP16، BF16 و INT8 بهصورت مقیاسپذیر ارائه میشود.

- فرمفکتورها هم نیازهای سرور استاندارد و هم الزامات محاسبات با کارایی بالا (HPC) را پوشش میدهند.

این مشخصات پایهای فراهم میکنند تا تصمیمگیریهای آگاهانه درباره استقرار بر اساس الزامات بار کاری خاص انجام شود؛ یعنی انتخاب فرمفکتور، توان مصرفی و ارتباط بین GPUها متناسب با نیاز عملیاتی.

A100 در مقابل GPUهای مصرفی مدرن: تفاوتهای عملی

NVIDIA A100 همچنان در آموزش مدلهای بزرگمقیاس عملکرد چشمگیری دارد، اما GPUهای مصرفی مدرن بسیاری از فاصله عملکردی را کاهش دادهاند. بهعنوان مثال، کارتهای NVIDIA RTX 4090 یا ۵۰۹۰ اغلب در توان عملیاتی آموزش با دقتهای FP16/BF16 از A100 پیشی میگیرند، مصرف انرژی کمتری دارند و هزینه عملیاتی بسیار پایینتری ایجاد میکنند. این کارتها بهویژه در کاربردهایی مانند Fine-Tuning، استنتاج (Inference) و آموزش مدلهای متوسط عملکرد بهینه دارند—حوزهای که بیشتر سازمانها بیشترین زمان خود را صرف آن میکنند.

علاوه بر پردازش AI، A100 قابلیتهای پیشرفته پردازش ویدئو را نیز ارائه میدهد، شامل شتابدهی در رمزگذاری، رمزگشایی و رندرینگ ویدئو. این ویژگیها آن را برای کاربردهای سنگین مانند تدوین ویدئو، استریمینگ و رندرینگ ویدئو در زمان واقعی مناسب میسازد.

کاربردهای عملی در دنیای واقعی

NVIDIA A100 توان پردازشی خود را در صنایع مختلف نشان داده و برای بارهای کاری هوش مصنوعی و محاسبات با کارایی بالا طراحی شده است. کاربردهای آن گاهی فراتر از انتظار ظاهر میشوند. بهعنوان مثال، در مدلهای پردازش زبان طبیعی مانند BERT، A100 توانایی پردازش زبان را تا ۲۴۹ برابر سریعتر از سیستمهای سنتی مبتنی بر CPU ارائه میدهد. این یعنی میتوانید چتباتها و ابزارهای زبانی واقعی با پاسخدهی بلادرنگ و در مقیاس مورد نیاز کسبوکار خود مستقر کنید.

در حوزه بهداشت و درمان، تیمها از A100 برای پردازش سریعتر تصاویر پزشکی و دادههای ژنتیکی استفاده میکنند. پزشکان اکنون میتوانند تصاویر پیچیده و توالیهای DNA را با سرعت و دقتی که امکان تشخیص سریعتر بیماریها را فراهم میکند، تحلیل کنند. بهبود نتایج بیماران مستقیماً از توانایی پژوهشگران در پردازش دادههای عظیم بدون انتظار ناشی میشود. در صنعت مالی نیز کاربرد مشابهی دیده میشود؛ تحلیل ریسک و ساخت پرتفویهای سرمایهگذاری با سرعتی که امکان تصمیمگیری مبتنی بر دادههای لحظهای را میدهد، نه دادههای دیروز.

فناوری Multi-Instance GPU (MIG) در A100 امکان اجرای همزمان چند شبکه عصبی و وظیفه روی یک GPU را فراهم میکند. این یعنی منابع محاسباتی بهطور کامل استفاده میشوند و بلااستفاده نمیمانند. این قابلیت بهویژه در مراکز داده مشترک اهمیت دارد، جایی که تقسیم منابع بهصورت بهینه و استخراج ارزش واقعی از سرمایهگذاری حیاتی است.

کارهای علمی نیز از هستههای Tensor و حافظه بزرگ A100 بهره میبرند. چه در پیشبینی وضعیت آب و هوا، مطالعه مواد یا شبیهسازیهای دینامیک سیالات، دقت بالا و پهنای باند حافظه لازم برای پردازش بارهای کاری سنگین فراهم میشود. محاسبات سریعتر انجام میشود و امکان پردازش دادههایی که پیشتر غیرممکن بود، مهیا میشود.

هنگامی که A100 در پلتفرم دیتاسنتری NVIDIA ادغام میشود، زیرساختی امن برای کارهای AI و HPC در مقیاس بزرگ فراهم میآید. ترکیب فناوری Multi-Instance، Tensor Coreها و حافظه پایدار، امکان رشد کارآمد سیستمها را ایجاد میکند. در نتیجه، از بارهای کاری عملیاتی نتایج واقعی خواهید دید و منابع شما به هدر نمیرود، حتی در مواجهه با انواع مختلف بارهای کاری.

راهنمای استقرار و پیکربندی A100

استقرار موفق NVIDIA A100 نیازمند بررسی دقیق ویژگیهای بار کاری، الزامات زیرساختی و استراتژیهای تخصیص منابع است تا بهرهوری و عملکرد بهینه حاصل شود.

مراحل انتخاب پیکربندی A100

چه زمانی باید این مقاله را استفاده کرد: برای سازمانهایی که قصد دارند A100 را در دیتاسنتر یا محیطهای ابری مستقر کنند.

- ارزیابی نیازهای حافظه بار کاری:

میزان استفاده حداکثری حافظه مدلهای AI و برنامههای HPC را تحلیل کنید تا مشخص شود پیکربندی ۴۰ گیگابایت یا ۸۰ گیگابایت مناسب است. توجه داشته باشید که حافظه بزرگتر نیاز به تقسیمبندی پیچیده مدلها (Model Partitioning) را کاهش میدهد. - بررسی الزامات فرمفکتور:

- نسخه PCIe برای ادغام در سرورهای استاندارد و سازگاری با زیرساخت موجود مناسب است.

- نسخه SXM برای دستیابی به حداکثر عملکرد و بهرهگیری از ارتباط NVLink در سیستمهای AI طراحیشده کاربرد دارد.

- برنامهریزی برای استفاده از Multi-Instance GPU (MIG):

تحلیل کنید که آیا بارهای کاری میتوانند از پارتیشنبندی MIG بهرهمند شوند؛ به این معنی که چند کار کوچک بهطور همزمان اجرا شوند و منابع GPU بهتر استفاده شود، به جای اختصاص کامل یک GPU به هر وظیفه. - محاسبه زیرساخت برق و خنکسازی:

اطمینان حاصل کنید که زیرساخت دیتاسنتر قادر به پشتیبانی از توان مصرفی طراحیشده (TDP) بین ۲۵۰ وات (PCIe) تا ۴۰۰ وات (SXM) باشد، شامل ظرفیت خنکسازی کافی و سیستمهای تأمین برق پایدار.

این مراحل پایهای را فراهم میکنند تا سازمانها بتوانند استقرار A100 را با کمترین ریسک، حداکثر کارایی و مقیاسپذیری بهینه انجام دهند.

مقایسه A100 PCIe در برابر A100 SXM

| ویژگی | A100 PCIe | A100 SXM |

|---|---|---|

| مصرف توان | ۲۵۰ وات TDP | ۴۰۰ وات TDP |

| پهنای باند حافظه | ۱.۵۵ ترابایت/ثانیه (۴۰GB) / ۲ ترابایت/ثانیه (۸۰GB) | ۱.۵۵ ترابایت/ثانیه (۴۰GB) / ۲ ترابایت/ثانیه (۸۰GB) |

| پشتیبانی از NVLink | ندارد | دارد (۶۰۰GB/s) |

| انعطاف استقرار | سرورهای استاندارد | سیستمهای طراحیشده ویژه |

| مقیاسپذیری چند GPU | محدود به پهنای باند PCIe | NVLink با سرعت بالا |

فرمفکتور SXM برای کاربردهایی که نیازمند حداکثر عملکرد و هماهنگی چند GPU هستند ایدهآل است، در حالی که نسخههای PCIe سازگاری بیشتری با سرورهای موجود دارند و ادغام آنها در زیرساختهای فعلی آسانتر است.

تفسیر: درک گزینههای پیکربندی، زمینه لازم را برای رسیدگی به چالشهای رایج در استقرار و بهینهسازی A100 فراهم میکند.

چالشها و راهکارهای رایج

موفقیت در پیادهسازی NVIDIA A100 بستگی به رسیدگی پیشگیرانه به بهینهسازی حافظه، تخصیص منابع و الزامات زیرساختی دارد که معمولاً بر عملکرد و بهرهوری تأثیر میگذارند.

چالش ۱: بهینهسازی حافظه برای مدلهای بزرگ

راهکار: استفاده از روشهایی مانند Gradient Checkpointing، آموزش با دقت مختلط (Mixed Precision Training) و استراتژیهای مدلپارالل (Model Parallelism) برای استفاده بهینه از ظرفیت حافظه بزرگ A100 هنگام آموزش مدلهایی که نزدیک به حد حافظه موجود هستند یا آن را فراتر میروند.

ظرفیت بالای حافظه A100 نیاز به تکنیکهای پیچیده بهینهسازی را کاهش میدهد، اما مدلهای زبان بزرگ و برنامههای پردازش تصاویر با رزولوشن بالا ممکن است همچنان نیازمند مدیریت دقیق حافظه برای دستیابی به عملکرد بهینه باشند.

چالش ۲: پیکربندی GPU چندنمونهای (Multi-Instance GPU – MIG)

راهکار: نمونههای MIG را بر اساس نیازهای منابع کاری پیکربندی کنید؛ معمولاً برای Inference نمونههای کوچکتر و برای برنامههای Training نمونههای بزرگتر ایجاد میشوند، در حالی که اطمینان حاصل شود هر نمونه از حافظه و منابع محاسباتی کافی برخوردار است.

پیکربندی صحیح MIG به سازمانها امکان میدهد با اجرای چندین بار کاری به صورت همزمان، حداکثر بهرهوری GPU را داشته باشند بدون اینکه عملکرد یکدیگر را مختل کنند. این قابلیت بهویژه در محیطهای تحقیقاتی مشترک و استقرارهای ابری ارزشمند است.

چالش ۳: زیرساخت خنککننده و تأمین برق

راهکار: ظرفیت خنککنندگی مناسب برای نیازهای TDP تا ۴۰۰ وات به ازای هر GPU فراهم کنید، سیستمهای تأمین برق قابل اعتماد را تضمین کنید و برای توزیع برق در سطح رک برنامهریزی کنید تا از پشتیبانی چندین دستگاه با مصرف برق بالا اطمینان حاصل شود.

برنامهریزی زیرساخت مرکز داده باید تراکم بالای مصرف برق در پیادهسازیهای A100 را در نظر بگیرد، بهویژه در پیکربندیهای با تراکم بالا که چندین GPU در نزدیکی هم نصب میشوند.

جمعبندی انتقال: پرداختن به این چالشها، زمینه را برای پیادهسازی موفق A100 فراهم میکند و تضمین میکند که عملکرد و بهرهوری مورد انتظار حاصل شود.

چالش ۴: متعادلسازی هزینه، دسترسی و عملکرد

کلاسترهای NVIDIA A100 قدرتمند هستند اما هزینه عملیاتی بالایی دارند. دسترسی به آنها برای تیمهای کوچک هنوز دشوار است، چرا که تقاضای مراکز داده همچنان از عرضه پیشی میگیرد. بسیاری از بارهای کاری به سختافزار سطح A100 نیاز ندارند و اجرای آنها روی رکهای A100 منجر به هزینه اضافی بدون کاهش زمان آموزش میشود.

راهکار: بارهای کاری بزرگ و حافظهبر را تنها زمانی روی سختافزار A100 اجرا کنید که لازم است و کارهایی مانند Fine-tuning، آزمایش و Inference را روی GPUهای کارآمدتر انجام دهید. این ترکیب به تیمها کمک میکند تا هزینهها را کنترل کنند و همزمان به سختافزار پرقدرت برای کارهای روزمره دسترسی داشته باشند.

آینده شتابدهی هوش مصنوعی

بارهای کاری هوش مصنوعی و HPC (محاسبات با کارایی بالا) همواره در حال تغییر هستند و NVIDIA A100 آماده پاسخگویی به نیازهای آینده در شتابدهی مراکز داده است. معماری Ampere با ارائه بهبودهای کاربردی—از جمله Tensor Coreهای نسل سوم، فناوری MIG (Multi-Instance GPU) و حافظه یکپارچه—نحوه ساخت، مقیاسبندی و استقرار مدلهای هوش مصنوعی و برنامههای HPC را تغییر داده است.

مدلهای بزرگتر و پیچیدهتر هوش مصنوعی به GPUهایی با حافظه بیشتر، پهنای باند بالاتر و توان محاسباتی بهتر نیاز خواهند داشت. پلتفرم مرکز داده NVIDIA به تکامل خود ادامه میدهد و بلوکها و فناوریهای جدیدی اضافه میکند که عملکرد، امنیت و مقیاسپذیری بارهای کاری سازمانی را بهبود میبخشد.

بهبودهای آینده بر یکپارچگی بیشتر سختافزار و نرمافزار تمرکز خواهند کرد تا مقیاسبندی در هزاران GPU آسانتر شود و منابع با کارایی بیشتری استفاده شوند. پشتیبانی بهتر از دادههای تقسیمشده، تخصیص پویا بار کاری و مانیتورینگ لحظهای کمک میکند تا مراکز داده کیفیت سرویس ثابت را در طیف گستردهای از برنامهها ارائه دهند.

سازمانها به طور فزایندهای به هوش مصنوعی برای نوآوری و تصمیمگیری متکی هستند، بنابراین توانایی استقرار سریع و امن راهحلها در مقیاس بزرگ اهمیت دارد. بنیاد A100—در کنار بهبودهای مداوم در پلتفرم NVIDIA—به سازمانها این امکان را میدهد که با چالشهای آینده هوش مصنوعی و HPC مقابله کنند، نتایج عملی ارائه دهند و راههای جدیدی برای استفاده از دادههای خود کشف کنند.

سؤالات متداول (FAQ) درباره NVIDIA A100

سؤال ۱: NVIDIA A100 GPU چیست؟

NVIDIA A100 یک GPU قدرتمند مرکز داده است که بر پایه معماری Ampere ساخته شده و برای شتابدهی آموزش هوش مصنوعی، استنتاج یادگیری عمیق (Deep Learning Inference)، تحلیل دادهها و محاسبات با کارایی بالا (HPC) طراحی شده است. این کارت شتاب بیسابقهای ارائه میدهد و از فناوری Multi Instance GPU (MIG) برای استفاده بهینه از منابع پشتیبانی میکند.

سؤال ۲: فناوری Multi Instance GPU (MIG) چگونه روی NVIDIA A100 کار میکند؟

فناوری MIG امکان تقسیم یک GPU A100 واحد به حداکثر هفت نمونه مستقل GPU را فراهم میکند. هر نمونه دارای حافظه، کش و منابع محاسباتی اختصاصی است و به این ترتیب چندین بار کاری به صورت همزمان اجرا میشوند، با تضمین کیفیت سرویس و ایزولاسیون در سطح سختافزار.

سؤال ۳: پیکربندیهای حافظه NVIDIA A100 چگونه است؟

A100 در دو پیکربندی حافظه HBM2e با ظرفیت ۴۰ و ۸۰ گیگابایت عرضه میشود. مدل ۸۰ گیگابایتی بالاترین پهنای باند حافظه جهان را با بیش از ۲ ترابایت بر ثانیه ارائه میدهد و امکان آموزش مدلهای بزرگتر AI و پردازش دادههای عظیم را به شکل بهینه فراهم میکند.

سؤال ۴: گزینههای استقرار NVIDIA A100 چیست؟

A100 در فرمفاکتورهای PCIe و SXM عرضه میشود. نسخههای PCIe برای ادغام در سرورهای استاندارد با TDP 250 وات مناسب هستند، در حالی که ماژولهای SXM تا TDP 400 وات را پشتیبانی میکنند و از اتصال NVLink پرسرعت برای مقیاسبندی چند GPU و دستیابی به عملکرد بهینه بهره میبرند.

سؤال ۵: NVIDIA A100 در مقایسه با نسل قبلی GPUها مانند NVIDIA Volta چگونه است؟

A100 تا ۲۰ برابر عملکرد آموزش AI بالاتری نسبت به نسل Volta ارائه میدهد. این کارت دارای Tensor Coreهای نسل سوم، CUDA Coreهای بهبود یافته و پهنای باند حافظه ارتقا یافته است که شتاب برتر برای بارهای کاری AI و HPC فراهم میکند.

سؤال ۶: آیا NVIDIA A100 میتواند بهصورت پویا با نیازهای مختلف بار کاری سازگار شود؟

بله، به لطف فناوری Multi Instance GPU (MIG) ،A100 میتواند به حداکثر هفت نمونه GPU تقسیم شود، که به مراکز داده امکان میدهد تخصیص منابع را بر اساس تغییرات بار کاری بهطور پویا تنظیم کنند و از بهرهوری بهینه اطمینان حاصل کنند.

سؤال ۷: چه نوع مدلهای هوش مصنوعی بیشترین بهره را از NVIDIA A100 میبرند؟

NVIDIA A100 برای مدلهای بزرگمقیاس هوش مصنوعی بیشترین کارایی را دارد؛ از جمله پردازش زبان طبیعی (NLP)، مدلهای توصیهگر مبتنی بر یادگیری عمیق (DLRM) و مدلهای هوش مصنوعی مولد (Generative AI). ظرفیت بالای حافظه، توان عملیاتی (Throughput) بالا و قابلیتهای پیشرفته Tensor Coreها باعث میشود این GPU در آموزش و اجرای چنین مدلهایی عملکرد چشمگیری ارائه دهد.

سؤال ۸: آیا NVIDIA A100 برای استقرار در مراکز داده از نظر امنیتی قابل اطمینان است؟

بله، A100 از ویژگیهای امنیتی پیشرفتهای بهره میبرد؛ از جمله Secure Boot مبتنی بر Hardware Root of Trust و یک تراشه امنیتی اختصاصی. این قابلیتها از دستکاری Firmware جلوگیری کرده و محیط محاسباتی امنی را در مراکز داده فراهم میکنند.

سؤال ۹: NVIDIA A100 چگونه از محاسبات با کارایی بالا (HPC) پشتیبانی میکند؟

A100 مجهز به Tensor Coreهای دقت دوگانه (Double Precision) است که تا حدود 9.7 ترافلاپس عملکرد FP64 ارائه میدهند. این توان محاسباتی برای شبیهسازیهای علمی، مدلسازیهای پیچیده و کاربردهای پیشرفته HPC بسیار حیاتی است. همچنین ظرفیت بالای حافظه و پهنای باند گسترده آن از اجرای برنامههای سنگین HPC پشتیبانی میکند.

سؤال ۱۰: چه نرمافزارها و فریمورکهایی برای NVIDIA A100 بهینه شدهاند؟

A100 توسط یک استک نرمافزاری جامع پشتیبانی میشود که شامل CUDA، cuDNN، TensorRT و کتابخانههای RAPIDS است. همچنین فریمورکهای محبوب هوش مصنوعی مانند TensorFlow، PyTorch و Apache MXNet برای بهرهگیری از بهبودهای عملکردی A100 بهینهسازی شدهاند.

سؤال ۱۱: شبکه در مراکز داده چگونه با NVIDIA A100 یکپارچه میشود؟

A100 از فناوریهای شبکه پرسرعت مانند NVLink و InfiniBand پشتیبانی میکند که ارتباط مؤثر GPU به GPU و استقرار مقیاسپذیر چند GPU را امکانپذیر میسازد. این قابلیتها برای خوشههای بزرگ آموزش AI و بارهای کاری HPC حیاتی هستند، زیرا تأخیر ارتباطی را کاهش داده و پهنای باند ارتباطی را افزایش میدهند.

سؤال ۱۲: آیا NVIDIA A100 میتواند در بارهای کاری واقعی AI و HPC نتایج ملموس ارائه دهد؟

بله. NVIDIA A100 بهطور گسترده آزمایش شده و در محیطهای عملیاتی واقعی، توانایی خود را اثبات کرده است. این GPU با کاهش چشمگیر زمان آموزش (Training Time)، افزایش توان عملیاتی در Inference و امکان استقرار مقیاسپذیر مدلهای بهینهشده AI در محیطهای تولید (Production)، نتایج قابل اندازهگیری ارائه میدهد.

سؤال ۱۳: مهمترین بهبودهای NVIDIA A100 نسبت به GPUهای نسل قبل چیست؟

بهبودهای کلیدی شامل Tensor Coreهای نسل سوم، افزایش توان هستههای CUDA، پهنای باند حافظه بالاتر، پشتیبانی از فناوری Multi-Instance GPU (MIG) برای تقسیمبندی سختافزاری منابع، و بهینهسازیهای معماری مبتنی بر Ampere است. این ارتقاها باعث افزایش چشمگیر عملکرد در آموزش و استنتاج مدلهای هوش مصنوعی و همچنین در کاربردهای HPC شدهاند.

جمع بندی

NVIDIA A100 نمایانگر استاندارد کنونی شتابدهی هوش مصنوعی در مراکز داده است و با ترکیب نوآوریهای معماری Ampere و ویژگیهای کاربردی مانند فناوری Multi-Instance GPU، به سازمانها این امکان را میدهد که بارهای کاری AI را از مرحله تحقیق تا تولید بهطور مؤثر مقیاسبندی کنند. ترکیب ظرفیت حافظه بزرگ، پشتیبانی از دقتهای متنوع و گزینههای استقرار منعطف، A100 را برای طیف کاملی از برنامههای مدرن هوش مصنوعی و HPC مناسب میسازد.